| 일 | 월 | 화 | 수 | 목 | 금 | 토 |

|---|---|---|---|---|---|---|

| 1 | 2 | 3 | ||||

| 4 | 5 | 6 | 7 | 8 | 9 | 10 |

| 11 | 12 | 13 | 14 | 15 | 16 | 17 |

| 18 | 19 | 20 | 21 | 22 | 23 | 24 |

| 25 | 26 | 27 | 28 | 29 | 30 | 31 |

- 챗지피티

- AI Fairness

- 지피티

- 설명가능성

- GPT

- 인공지능 신뢰성

- 딥러닝

- Ai

- cnn

- GPT-3

- 인공지능

- Transformer

- Tokenization

- gpt2

- 트랜스포머

- trustworthiness

- Bert

- ML

- ChatGPT

- nlp

- fairness

- DevOps

- MLOps

- 케라스

- XAI

- 자연어

- 챗GPT

- word2vec

- 신뢰성

- 머신러닝

- Today

- Total

research notes

DARPA 설명가능성 프로그램 회고 (DARPA’s Explainable AI (XAI) program: A retrospective) 본문

DARPA 설명가능성 프로그램 회고 (DARPA’s Explainable AI (XAI) program: A retrospective)

forest62590 2022. 7. 2. 23:03* 다르파(DARPA, Defense Advanced Research Projects Agency)가 수행한 XAI Program에 대한 Summary 기고문 해석

1. Abstract

DARPA는 사용자가 인공지능 시스템을 더 잘 이해하고(understand), 신뢰하며(trust) 효과적으로 관리할 수 있도록 하기 위해 2015년 설명가능한 인공지능(XAI) 프로그램 개발을 공식화하였으며, 2017년부터 4년 간의 XAI 연구 프로그램이 시작되었다. 그리고 XAI 연구 프로그램이 2021년에 종료됨에 따라 무엇이 성공하고 실패하였는지 그리고 무엇을 배웠는지에 대해 기술하였다.

2. Creation of XAI

머신러닝의 극적인 성공과 더불어 인공지능(AI) 기술에 대한 활용은 폭발적으로 증가하였고 점차 기술이 발전함에 따라 스스로 인지하고, 배우고, 결정하고, 행동하는 자율 시스템이(Auonomous system) 나타날 것으로 예상된다. 그러나, 이러한 시스템은 엄청난 이점을 제공하지만 반면에 사용자에게 자신이 내린 결정과 조치를(action)에 대한 근거를 설명할 수 없기 때문에 효율적이지 않다. 이 문제는 지능적이고 자율적이며 안정적인 시스템을 개발해야 하는 문제에 직면한 미국 국방부(DoD)에게 특히 중요하다. 즉, 설명가능한 AI는 사용자가 인공지능에 대해 신뢰하며 효과적으로 관리하는 데 필수적이다.

AI 초기의 주요 알고리즘은 logical 및 symbolic 기반이었다. 이러한 초기 시스템은 사람이 읽을 수 있는 기호에 대해 어떤 논리적인 형태를 가졌다. 초기 인공지능 시스템은 추론 단계시 그 흐름을 확인 할 수 있었으며 이는 설명의 기초가 될 수 있다. 또한, 이러한 시스템을 설명 가능하게 만드는 방법에 대한 중요한 연구가 있었다(Shortliffe & Buchanan, 1975; Swartout, Paris, & Moore, 1991; Johnson, 1994; Lacave & D ́ıez, 2002; Van Lent, Fisher, & Mancuso, 2004).

그러나 이러한 초기 AI 시스템은 비효율적이었다. 즉, 구축하기에 비용이 많이 들고 현실 세계의 복잡성을 잘 반영하지 못하는 것으로 판명되었다. 이후 인공지능 분야의 성공은 연구원들이 서포트 벡터 머신(SVM), 랜덤 포레스트, 확률 모델 및 신경망과 같은 새로운 기계 학습 기술을 개발함에 따라 이루어졌다. 이러한 새로운 모델은 기존 방식에 비해 훨씬 더 효과적이었으나 필연적으로 더 불투명하고 설명하기 어렵다. 따라서, 모든 사람들은 이해불가해 보이는 AI 시스템을 이해하고, 신뢰하고, 관리하는 방법을 알고 싶어했다.

2015년에는 설명가능성을 제공하기 위한 초기 아이디어도 등장하였다. 일부 연구자들은 디컨볼루션(deconvolution) 네트워크를 사용하여 컨볼루션 네트워크 계층을 시각화하는 것과 같은 딥러닝 기술을 연구하였다(Zeiler & Fergus, 2014). 다른 연구자들은 Bayesian Rule Lists(Letham, Rudin, McCormick, & Madigan, 2015)와 같이 해석가능한 모델을 학습하기 위한 기술을 연구했다. 다른 연구자들은 LIME(Ribeiro, Singh, & Guestrin, 2016)과 같이 대략적으로(approximate) 설명가능한 모델을 추론하기 위해 model-agnostic explanation한 기술을 개발하고 있었다. 반면 다른 연구원들은 설명 인터페이스의 심리적 및 인간-컴퓨터 상호작용 측면을 평가하고 있었다. (Kulesza, Burnett, Wong, & Stumpf, 2015)

DARPA는 1년 동안 연구자들을 대상으로 가능한 연구 전략을 분석하고 프로그램의 목표와 구조를 공식화하였고, 2016년 8월 DARPA는 (Call for proposals)DARPA-BAA-16-53을 발표하였다.

2.1. XAI Program Goals

설명가능 인공지능 프로그램에 명시된 목표는 효과적인 설명 기법을 결합하여 최종 사용자가 AI 시스템을 이해 및 적절한 신뢰하고 효과적으로 관리하게 하는 새로운 또는 개선된 머신러닝 기술 도구를 개발하는 것이다.

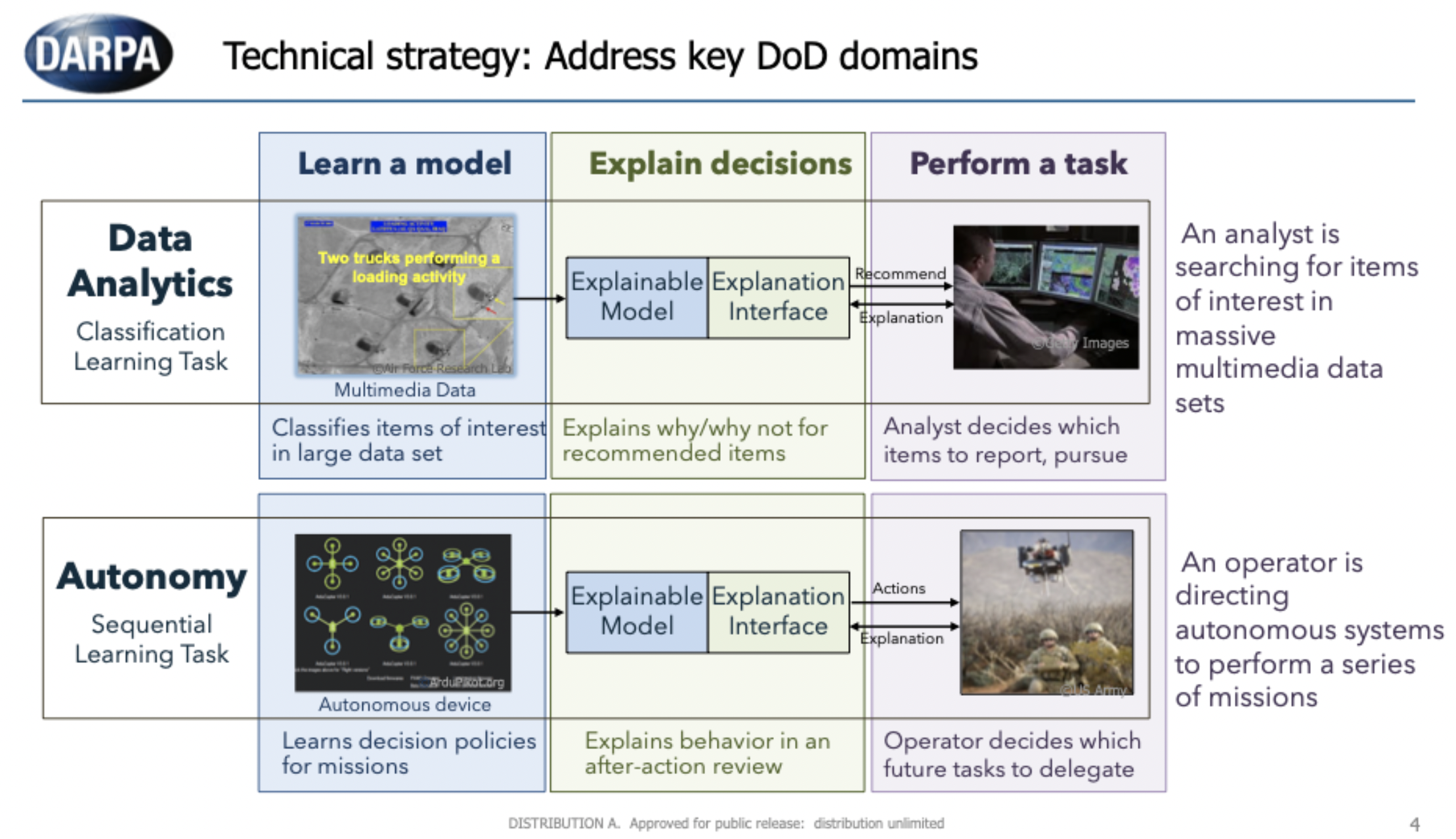

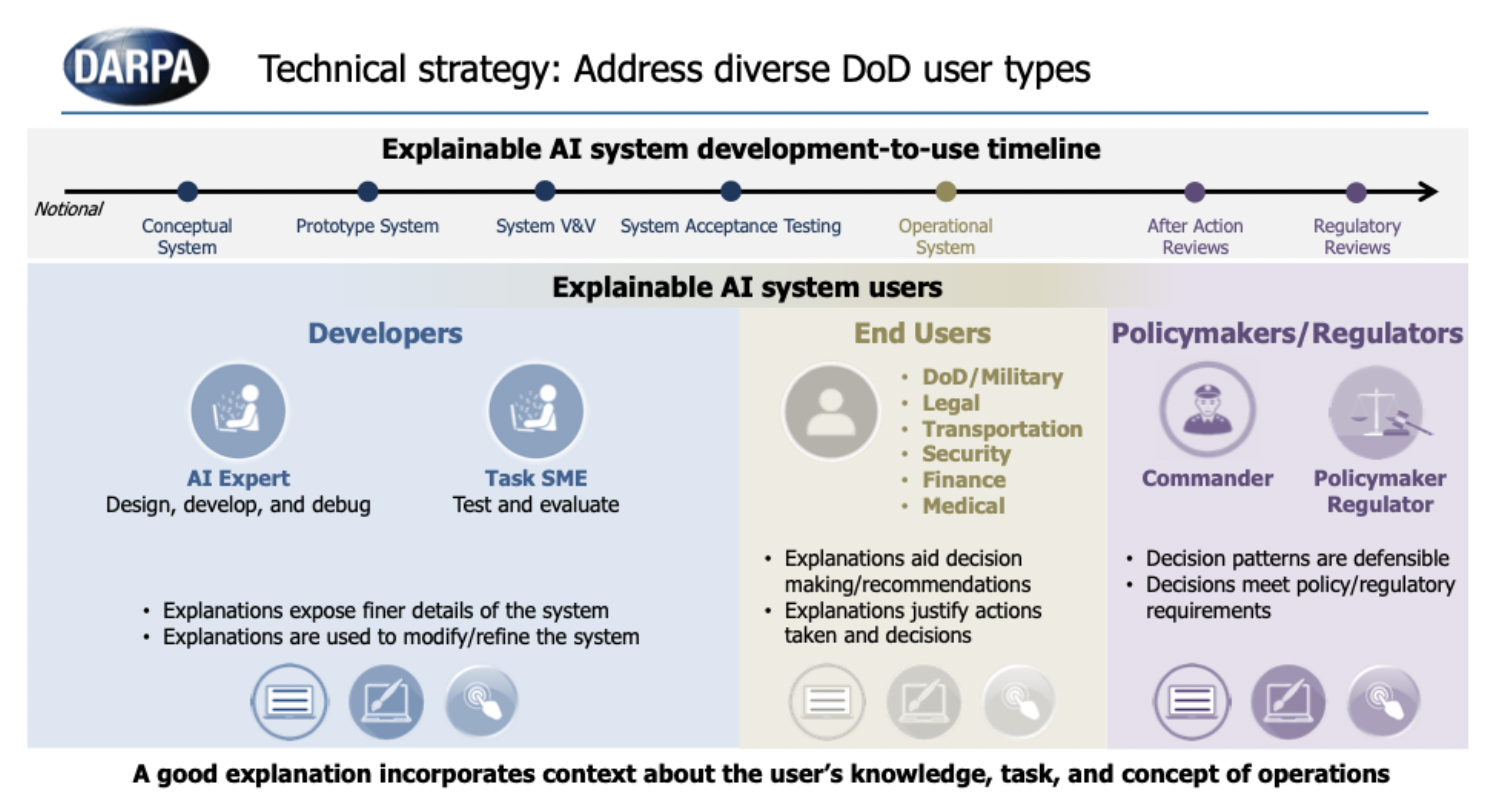

XAI의 활용 대상은 AI 시스템에서 생성된 결정이나 권장사항 또는 AI 시스템이 취하는 조치(action)에 의존하는 최종 사용자이며, 해당 사용자 들은 시스템의 근거를 이해해야 할 필요가 있다. 예를 들어, 빅데이터 분석 시스템에서 권장사항을 받는 인텔리전스 분석가는 추가 조사를 위해 시스템이 특정 활동을 권장한 이유를 이해해야 한다. 마찬가지로 자율 시스템을 사용하는 운영자는 시스템의 의사 결정 모델을 이해해야 향후 임무에서 적절하게 사용할 수 있다. XAI 개념은 사용자가 시스템의 전반적인 강점과 약점을 이해할 수 있도록 설명을 제공하는 것이다. 따라서 미래의 다른 상황에서 어떻게 행동할 것인지에 대한 이해도를 높일 뿐만아니라 사용자가 시스템의 오류를 수정하도록 할 수도 있다.

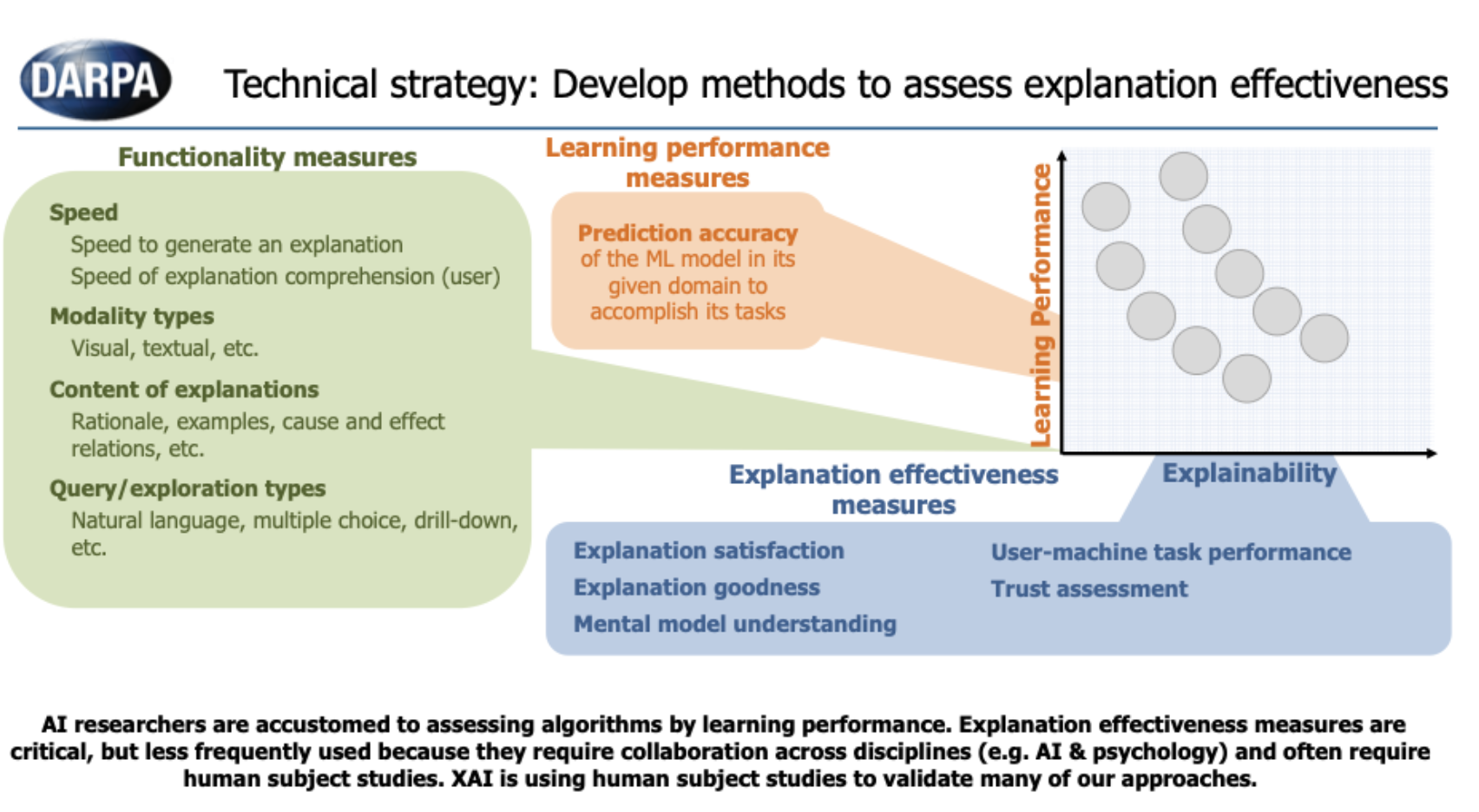

XAI 프로그램은 기계학습 성능(예: 예측 정확도)과 설명가능성이 상호 영향을 미친다는 가정을 전제로 한다 . 종종 가장 높은 성과를 내는 방법(예: 딥러닝)은 가장 설명하기 어렵고 가장 설명하기 쉬운 방법(예: 의사 결정 트리)은 종종 정확도가 낮다. XAI 프로그램은 새로운 머신러닝 및 설명가능성 기술과 관련된 포트폴리오를 만들어 미래의 실무자들에게 퍼포먼스(성능)와 설명가능성 간의 트레이드 오프를 기준으로 한 다양한 설계 옵션을 제공하기는 것을 목표로 하였다. 응용 프로그램이 더 높은 성능이 필요한 경우 XAI 포트폴리오에는 설명가능성 수준이 낮고 고성능의 딥러닝 기술을 고려한다. 반면 응용 프로그램에 더 많은 설명가능성이 요구되는 경우 XAI에는 더 높은 성능의 해석 가능한 모델을 고려한다.

2.2. XAI Program Structure

이 프로그램은 아래 그림 1과 같이 세 가지 주요 기술 영역(Technical Areas, TA)으로 구성되었다.

TA1: 효과적인 설명을 위한 새로운 XAI 머신러닝 및 설명 기술의 개발

TA2: 설명 심리학 이론을 요약, 확장 및 적용하여 설명 심리학을 이해

TA3: 데이터 분석과(data analytics) 자율성이라는(autonomy) 두 가지 도전 문제 영역에서 새로운 XAI 기술에 대한 평가

XAI 프로그램의 일정은 다음과 같이 두 단계로 구성된다. (Phase1) 기술 데모(18개월) 및 (Phase2) 비교 평가(30개월)

1단계에서 개발자는 자체 테스트 시나리오에 대해 설명가능성 기술을 시연하도록 요청받았다. 2단계는 개발자가 정부 평가자가 정의한 두 가지 공통 문제(그림 2) 중 하나에 대해 설명가능성 기술을 테스트 하는 것이다. 2단계가 끝나면 개발자는 프로토타입 소프트웨어를 오픈 소스 XAI 툴킷에 제공하는 것으로 계획되어 있다.

3. XAI Program Development

2017년 5월 XAI 개발이 시작되었다. 설명가능 기술을 개발하기(TA1) 위해 11개의 연구팀이 선택되었고 설명의 심리학적 모델을 개발하기(TA2) 위해 한 팀이 선택되었다. 평가는 해군 연구소에서 수행하였으며, 다음은 이러한 개발 및 프로그램이 끝날 때의 최종 작업 상태를 요약하였다. (2018년도의 XAI 프로그램 개발 현황에 대한 중간 요약은 [Gunning and Aha, 2019]에서 제공된다.)

3.1. XAI Explainable Learner Approaches

이 프로그램은 연구자들이 훈련 과정(training process), 모델 표현(model representations) 그리고 중요하게는 설명 인터페이스를 조사할 것으로 예상했다. 모델 표현을 위해 세 가지 일반적인 접근 방식이 구상되었다. 해석가능한 모델 접근 방식은 본질적으로 머신러닝 전문가가 더 설명하기 쉽고 ML 모델을 개발하려고 하는 것이다. 심층설명(deep explanation) 접근 방식은 예측 외에도 설명을 생성하기 위해 딥러닝 또는 하이브리드 딥러닝 접근 방식을 활용할 것이다.마지막으로 모델 유도 기술은 더 불투명한 블랙박스 모델에서 대략적인 설명 가능한 모델을 생성합니다. 설명 인터페이스는 사용자를 모델에 연결하여 의사 결정 프로세스를 이해하고 상호 작용할 수 있도록 하는 XAI의 중요한 요소가 될 것으로 예상된다.

연구가 진행됨에 따라 11개의 XAI 팀은 다루기 쉬운 확률 모델(Roy et al. 2021) 및 인과모델(Druce et al. 2021)과 같은 여러 머신 러닝 접근 방식과 강화학습 알고리즘에 의해 생성된 상태 머신(Koul et al. 2019, Danesh et al. 2021), 베이지안 티칭(Yang et al. 2021), 시각적 돌출 맵(Petsiuk 2021, Li et al. 2021, Ray et al. 2021, Alipour et al. 2021) et al. 2021), 네트워크 및 GAN 해부(Ferguson et al. 2021)와 같은 설명 기술을 연구했다. 아마도 가장 도전적이고 가장 독특한 기여는 설명의 효과를 평가 할 때 잘 설계된 심리학적 실험을 수행하기 위한 머신러닝과 설명 기술의 조합에서 비롯된 것이다.

프로그램이 진행됨에 따라 사용자의 스펙트럼과 개발 일정에 대한 보다 정교한 이해도 얻게 되었다 (그림 3).

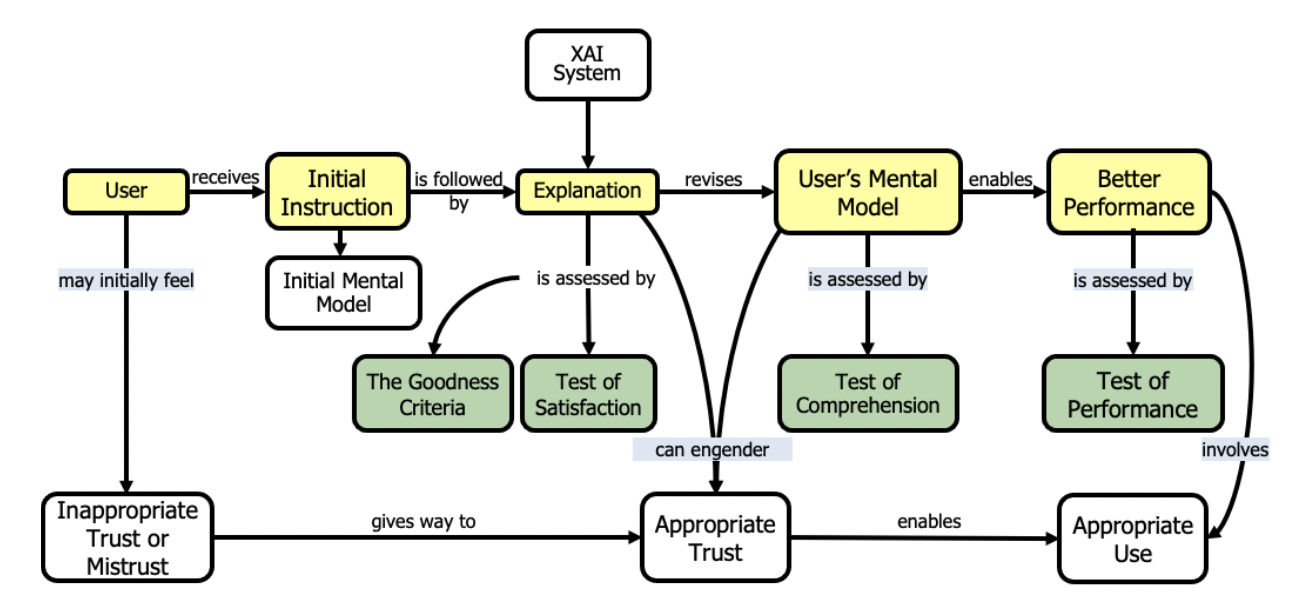

3.2. Psychological Models of Explanation

프로그램 구조는 설명에 대한 기초적인 심리학적 이해의 필요성을 예측했다. XAI 개발자와 평가팀을 돕고 현재의 심리학적 설명 이론을 요약하기 위해 한 팀이 선택되었다. 이 작업은 설명의 심리학에 대한 광범위한 문헌 조사와 AI의 설명 가능성에 대한 이전 작업(...IHMC 문헌 조사 참조)으로 시작되었다. 원래 이 팀은 (1) 현재의 설명 이론에 대한 요약을 제공하고 (2) 해당 설명 이론 기반으로 설명의 계산 모델을 개발하도록 요청받았다. 그리고 (3) XAI 개발자의 평가 결과를 활용하여 계산 모델을 검증한다. 계산 모델을 개발하는 것은 다소 무리로 판단 되었으나 팀은 해당 영역에 대한 깊은 이해를 얻었고 또한 설명 모델을 성공적으로 생성했다.

이러한 설명 모델은 DoD 인간 대상 연구 지침에 따라 수행된 신중하게 설계된 사용자 연구와 관련된 효과적인 평가 접근 방식을 지원하는 데 중요했습니다. 위 그림은 XAI 설명 프로세스의 최상위 기술 모델을 보여준다.

3.3. Evaluation

평가는 원래 데이터 분석 및 자율성 영역 내에서 공통 문제 집합을 기반으로 하는 것으로 계획되었다. 그러나 광범위한 문제 영역에 걸쳐 다양한 접근 방식을 탐색하는 것이 더 가치가 있다는 것이 곧 분명해졌다. 프로그램 마지막 해의 성과를 평가하기 위해 미 해군연구소(NRL)가 이끄는 평가팀이 ESS(설명 채점 시스템)를 개발했다. 도메인 전문가 그룹의 권장 사항을 기반으로 하고 콘텐츠 유효성 비율(CVR)을 사용하여 검증된 ESS는 XAI 사용자 연구의 설계를 평가하기 위한 정량적 메커니즘을 제공한다. ESS는 작업, 도메인, 설명, 설명 인터페이스, 사용자, 가설, 데이터 수집 및 분석을 포함하여 사용자 연구의 여러 요소를 평가한다. XAI 평가 척도는 기능 척도, 학습 수행 척도, 설명 효과 척도를 포함한다. 설명의 효과를 정확하게 평가하려면 사용자 연구를 신중하게 설계하는 것이 중요하다. 종종 XAI 알고리즘의 성능을 평가하기 위해 여러 유형의 측정(예: 성능, 기능, 설명 효율성)이 필요하다. XAI 사용자 연구 설계는 까다로울 수 있으며 일반적으로 프로그램에서 가장 효과적인 팀에는 상당한 심리학 전문 지식을 갖춘 동료가 있었다.

4. XAI Results, Lessons Learned

프로그램 기간 동안 세 가지 주요 평가가 수행되었다. XAI 기술의 효율성을 평가하기 위해 사용자 연구를(user studies) 설계하고 실행하였는데, 사용자 연구는 여전히 설명을(explanations) 평가하기 위한 gold standard이기 때문이다. XAI 프로그램 연구원이 수행한 사용자 연구에는

직접 또는 Zoom을 통해 연구팀이 실험에 대해 가이드를 준

약 1900명의 참가자 및 Amazon Mechanical Turk와 같은 연구팀의 가이드를 받지 않은 10,800명의 참가자를 포함하여 약 12,700명이 참가하였다. 미국 국방부(DoD)가 자금을 지원하는 모든 인간 대상 연구에 대한 정책에 따라 각 연구 프로토콜은 지역 기관 검토 위원회(Institutional Review, Board, IRB)에서 검토한 다음 DoD 인간 연구 보호 사무소에서(human research protection office) 프로토콜과 현지 IRB 결과를 검토하였다.

이러한 사용자 연구 과정에서 몇 가지 핵심 사항이 확인되었다.

- 사용자는 의사결정만 제공하는 시스템보다 설명과 함께 의사결정을 제공하는 시스템을 선호한다. 설명이 제공할 수 있는 가장 가치있는 태스크는 사용자가 인공지능 시스템이 어떻게 결정을 도출해 내는지 이해하는 것이다. [Supported by 11 experiments across performer teams]

- 설명에 대한 사용자 태스크 퍼포먼스를 향상시키기 위해 해당 태스크는 AI 설명이 도움이 될만큼 충분히 복잡해야 한다. [PARC, UT Dallas]

- 설명을 해석하기 위한 사용자 인지 부하는 사용자의 퍼포먼스를 방해할 수 있다. 따라서, 이전의 관점과 결합하여 사용자 퍼포먼스 향상을 위하여 설명 및 태스크 난이도는 조정될 필요가 있다.

- 사용자 성능을 향상시키기 위해 포인트, 설명 및 작업 난이도를 보정해야 합니다.[UCLA, 오리건 주]

- 설명은 AI가 정확하지 않을 때 더 도움이 되며 특히 극단적인 경우에(edge cases) 유용하다. [UCLA, Rutgers]

- 설명가능성 효과에 대한 측정 방법은 시간이 지남에 따라 달라질 수 있다. [Raytheon, BBN]

- 조언가능성(Advisability)는 단독으로 설명을 제공하는 것 보다 유저의 신뢰성을 상당하게 향상시킬 수 있다. [UC Berkeley]

- XAI는 사용자와 XAI 시스템에 대한 멘탈 모델을 측정하고 정렬하는 데 유용하다. [Rutgers, SRI]

- 마지막으로 XAI 프로그램이 진행된 지난 해부터 코로나19 팬데믹이라는 유례없는 세계적 대유행 시기에, 프로그램 수행 팀은 XAI 대면으로 설문이 불가능할 경우 사용자 연구를 수행하기 위해 웹 인터페이스를 설계하기 위한 모범 사례를 개발했다. [OSU, UCLA, Dikkala 2021]

앞서 언급하였듯이, 기본적으로 학습 퍼포먼스와 설명가능성 사이에는 트레이드오프 관계가 있다. 그러나 프로그램 코스를 통하여 설명가능성이 퍼포먼스를 개선할 수 있다는 점을 파악했다. (Kim et al. 2021, Watkins et al. 2021). 직관적인 관점으로 부터, 설명을 생성해 내기 위해 시스템을 학습하는 것은 추가적인 오차함수(loss function), 학습 데이터(training data) 또는 기타 다른 메커니즘과 같은 추가적인 체계를 제공하고, 이것은 시스템이 세계에 존재하는 더 효과적은 표현 체계를 학습하는 것을 장려한다.

이것이 모든 케이스에 대해 정답이 아닐 수도 있고, 언제 설명가능성 기술이 성능 기준에 적합한지 구별하는 가장 중요한 작업이 남아있다. 이러한 작업은 미래의 XAI 시스템이 사용자가 필요로 하는 설명을 만족함과 동시에 현재 시스템보다 더 성능을 좋게 할 것이라는 예상을 가능하게 한다.

5. State of the world, AI, and XAI after DARPA program in 2021

현재 XAI에 대한 보편적인 솔루션은 없다. 앞서 논의한 바와 같이 사용자 유형에 따라 다른 유형의 설명이 필요하며 이것은 우리가 다른 사람들과 상호 작용하는 것과 다르지 않다. 예를 들어 의사가 동료 의사, 환자 또는 의료 심사 위원회에 진단을 설명해야 한다고 생각해 볼 수 있다. 아마도 미래의 XAI 시스템은 광범위한 사용자 유형 내에서 특정 사용자에게 설명을 자동으로 보정하고 전달할 수 있을 것으로 생각되나 현재의 기술로는 구현 가능하지 않다.

XAI 개발의 어려움 중 하나는 설명의 효율성을 측정하는 것이다. DARPA의 노력은 XAI 관련 기초 기술 개발에는 도움이 되었으나 인적 요소(human factor) 및 심리학(psychology)을 포함한 더 많은 연구가 수행되어야 한다. 효과적인 설명이 ML 시스템의 핵심 기능이 되기 위해서는 설명에 대한 효과의 척도가 잘 확립되고(well established), 잘 이해되어야(understood) 함은 물론 개발자들이 쉽게 구현할 수 있어야 한다.

UC Berkeley의 결과(Kim et al. 2021)는 AI 시스템이 사용자로부터 조언을 받을 수 있는 능력인 조언가능성(advisability)이 단순히 설명하는 것을 넘어 사용자 신뢰를 향상시킨다는 흥미로운 결과를 제시하였다. 확실히 사용자는 인간이 서로 피드백을 제공할 수 있는 것과 같은 방식으로 시스템의 동작을 신속하게 수정할 수 있는 시스템을 선호할 것이다. 설명을 생산하고 소비할 수 있는 AI 시스템은 인간과 AI 시스템 간의 긴밀한 협업을 가능하게 하는 핵심이 될 것이다.

XAI 기술을 효과적으로 개발하기 위해서는 컴퓨터 공학, 머신러닝, 인공지능, 휴먼팩터, 심리학 등 여러 분야에 걸친 긴밀한 협업이 필요하다. 보통 연구자들은 단일 도메인에 집중하는 경향이 있기 때문에 이는 특히 어려울 수 있으나, 아마도 미래에는 XAI 관련 연구 분야가 여러 분야의 교차점에서 만들어질 것으로 생각된다. 따라서 다양한 프로그램 아티팩트(예: 코드, 논문, 보고서 등)와 4년 동안 DARPA XAI 프로그램 수행 과정에서 얻은 교훈을 공개적으로 접근 가능한 곳에 배포하기 위해 Explainable AI Toolkit(XAITK, https://xaitk.org/)를 구축하였다. 이 툴킷은 AI 기능을 활용함을 물론 AI 성능을 검증하고 신뢰해야 하는 모든 사람들에게 유용하게 활용 될 것으로 생각한다.

오늘날 우리는 2015년보다 인공지능에 대해 아마도 더 정확하게 이해하고 있다(즉, 딥러닝의 가능성과 한계에 대해 더 정확하게 이해하고 있다). XAI 프로그램은 XAI 연구(프로그램 내부 및 외부 모두)를 자극하는 촉매 역할을 하였다고 생각되며, 계속해서 설명이 필요한 새로운 인공지능이 기술이 개발됨에 따라 XAI는 당분간 활발한 연구분야로 인식 될 것이다.

'인공지능 신뢰성 > eXplainable AI(XAI)' 카테고리의 다른 글

| Partial Dependency Plot (PDP plot) (0) | 2022.06.23 |

|---|---|

| Permutation Feature Importance(PFI) (0) | 2022.03.23 |

| SHAP (SHapley Additive exPlanations) (0) | 2022.03.16 |

| LIME (Linear Interpretable Model-agnostic Explanation) (0) | 2022.02.26 |

| Image-specific Saliency (0) | 2022.02.22 |